企业落地RAG系统痛点:

-

技术公司维护着大量的专有文档,如培训材料、设计文档和研究成果。

-

工程师,尤其是新员工,需要快速查询这些文档或吸收其中的新知识。

-

这些领域特定的文档通常包含许多技术社区特有的缩写和术语,使得导航变得复杂。

Golden-Retriever系统:在文档检索前增加了一个基于反思的问题增强步骤,用于识别术语、根据上下文澄清其含义,并相应地增强问题。

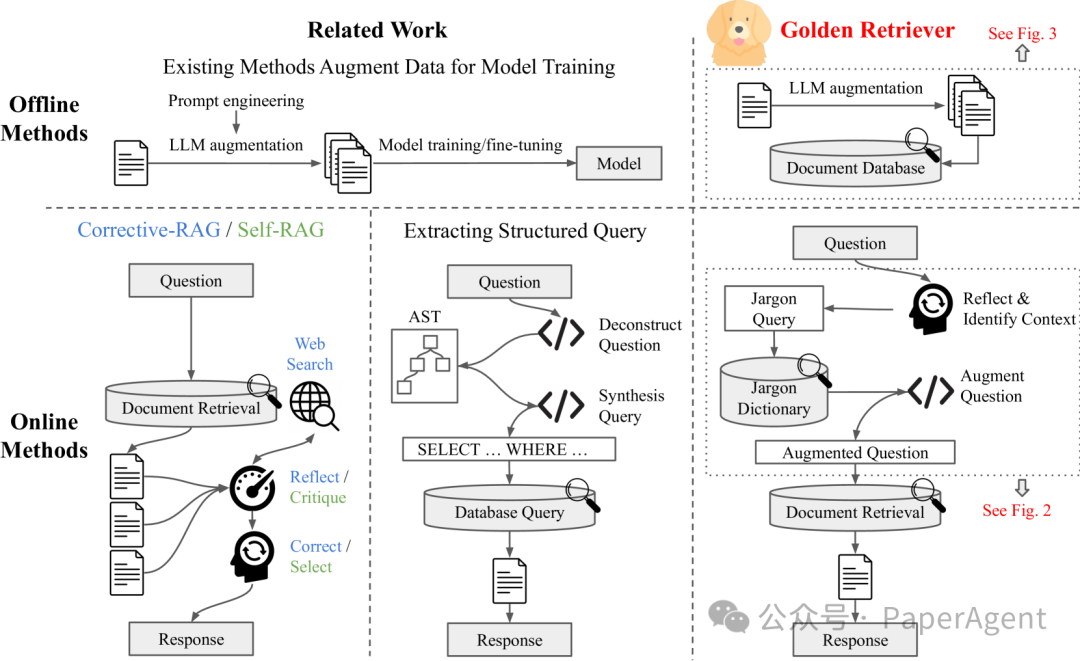

一个比较Golden-Retriever与相关工作的示意图。两种类型的方法:离线和在线。在左上角,现有的离线方法使用大型语言模型(LLMs)生成训练数据集。右上角展示了Golden-Retriever离线方法,利用LLMs增强文档数据库,为在线阶段做准备。在线方法在图的下半部分描绘。从左下到右下:Corrective RAG和Self-RAG在文档检索步骤后修改RAG的响应。如果用户的问题含糊不清或缺乏上下文,RAG无法检索到最相关的文档,限制了这些方法的有效性。另一种方法将问题解构为抽象语法树(AST),并相应地合成SQL查询,提高了查询的保真度,但仅适用于SQL查询。Golden-Retriever的方法反思问题,识别其上下文,并在文档检索之前通过查询术语字典来增强问题。增强后的问题允许RAG忠实地检索最相关的文档,即使存在含糊的术语或缺乏明确的上下文。

Golden-Retriever的组成:包含离线(offline)和在线(online)两个部分。

-

离线部分是数据预处理步骤,发生在知识库聊天机器人部署之前。

-

在线部分是每次用户提问时发生的交互过程。

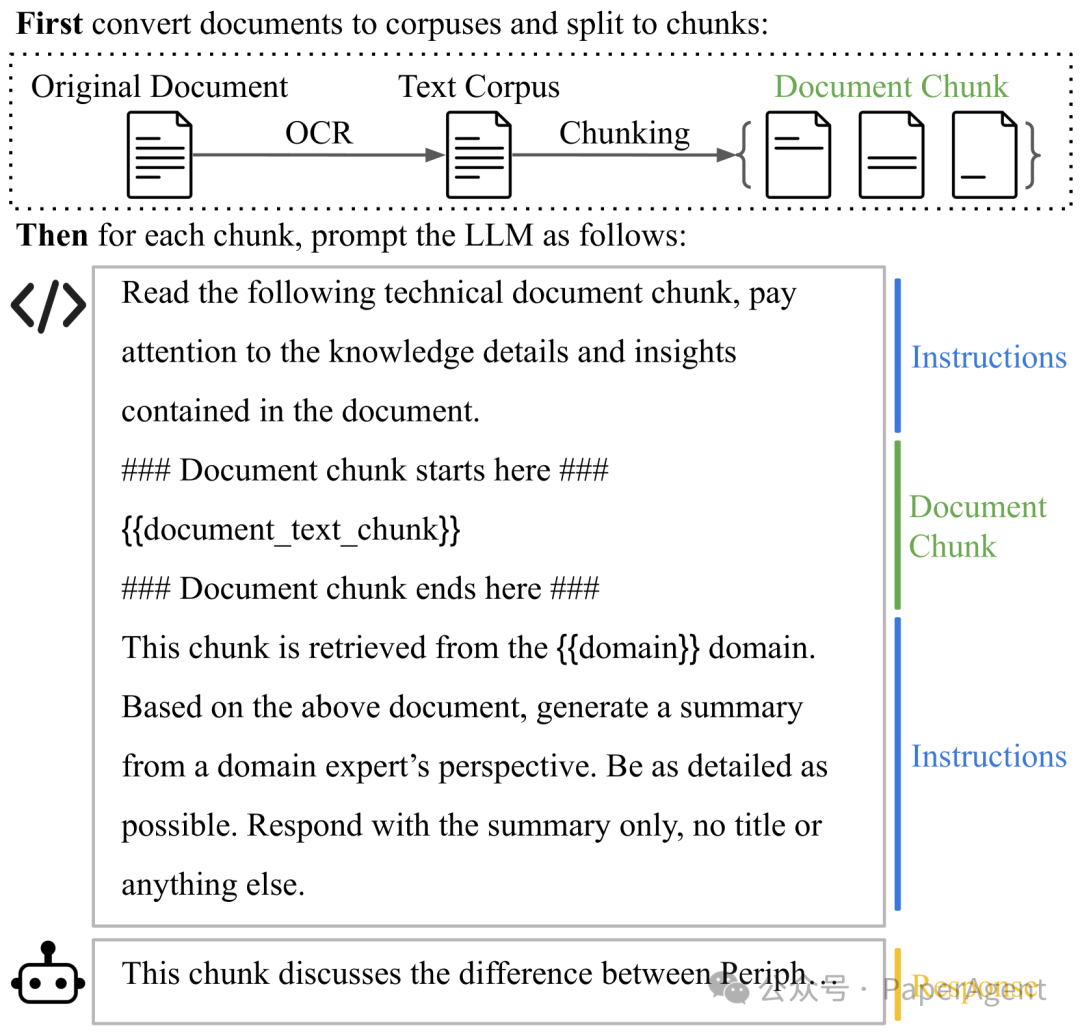

离线文档增强(LLM-Driven Document Augmentation)

-

目的:增强文档数据库,提高检索文档的相关性。

-

过程:收集公司原始文档,使用OCR技术提取文本,并将其分割成较小的块,以便处理。

-

增强:使用大型语言模型(LLM)为每个文本块生成摘要,从而利用LLM的语义理解和上下文学习能力。

文档预处理和LLM驱动的文档增强过程的示例提示实施的插图

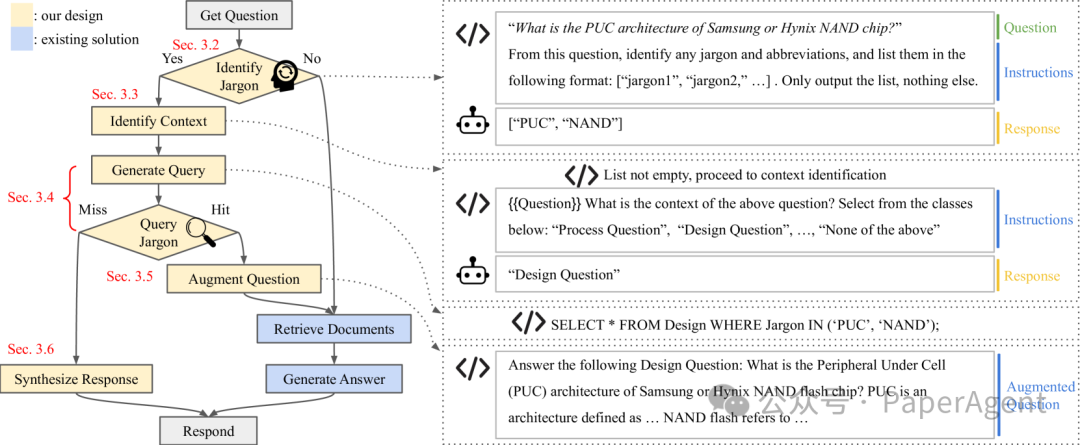

在线过程(online):每次用户提问时,系统通过LLM识别问题中的术语和上下文,查询术语字典,然后增强原始问题,以便RAG框架检索最相关和准确的文档。

-

在线过程:

-

1.1 识别术语(Identify Jargons):识别用户问题中的术语和缩写,为确保准确解释,使用LLM提取并列出所有潜在的术语和缩写。

-

1.2 确定上下文(Identify Context):确定问题中术语的上下文,使用LLM通过提示模板来识别问题上下文。

-

1.3 查询术语(Query Jargons):使用已识别的术语查询术语字典,获取扩展定义、描述和注释。

-

1.4 增强问题(Augment Question):结合原始问题、上下文信息和详细的术语定义,形成增强后的问题,以提供清晰的上下文并解决任何歧义。

-

1.5 查询未命中响应(Query Miss Response):如果系统在字典中找不到某些术语的相关信息,Golden-Retriever有一个备选机制,合成一个响应,指示由于缺少信息而无法回答问题。

-

左侧是Golden-Retriever在线推理部分的工作流程图。右侧是系统与LLM在工作流程中间步骤的示例交互。系统提示LLM生成中间响应,这些响应被保存、访问,并用于工作流程中后续的步骤。

通过在特定领域的问答数据集上的评估,Golden-Retriever在多个开源LLM上表现出色,与传统的RAG方法相比,显著提高了答案的准确性。与Vanilla LLM和RAG相比,Golden-Retriever分别将Meta-Llama-3-70B的总分提高了79.2%和40.7%。在测试的所有三种大型语言模型中,平均将得分提高了57.3%。

与传统的LLM微调方法相比,Golden-Retriever避免了计算成本高、泛化能力差和容量限制等问题。

问答实验结果。使用针对工程师新员工培训文档中的六个不同领域的测验作为测试问题。所有问题都是多项选择题。显示的是五次试验的平均得分。最佳得分用粗体显示。

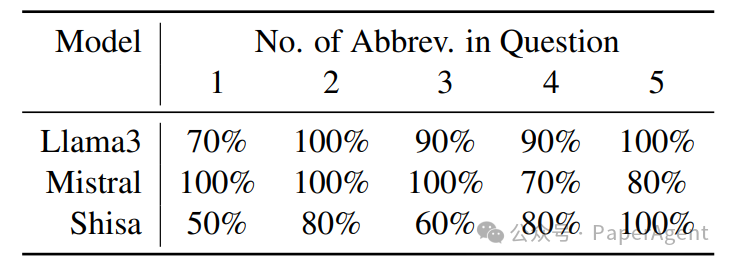

缩写识别实验的结果表明,Golden-Retriever系统中使用的LLM能够有效地识别问题中的缩写,这对于提高问题解答的准确性至关重要。

附录

QA对示例

展示了一些用于问题回答实验的评估数据的非保密实例,如下所示:

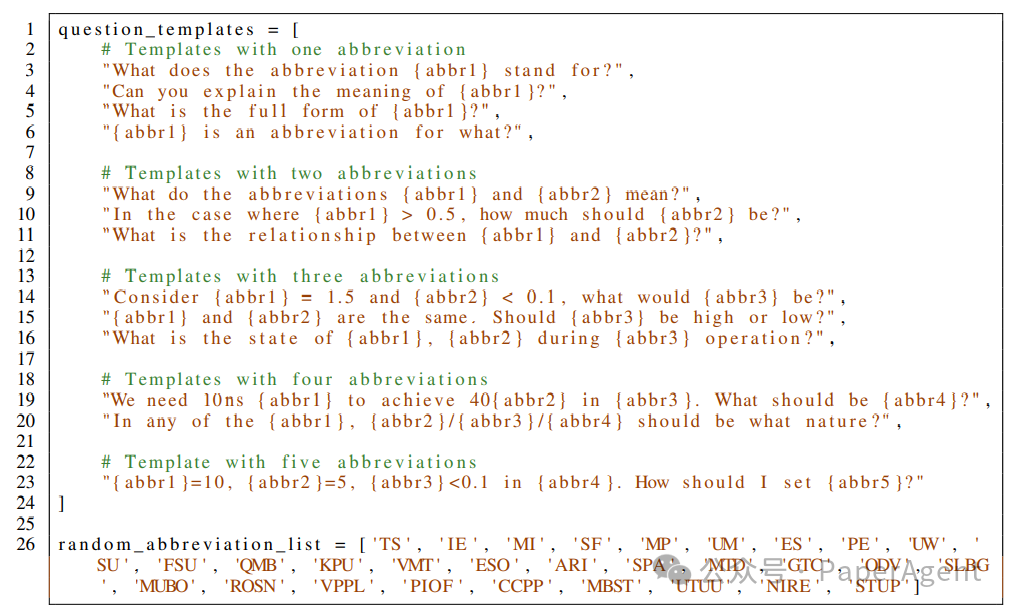

合成数据集生成模板

以下是用于生成缩写识别实验中随机缩写的问题模板和随机缩写列表。

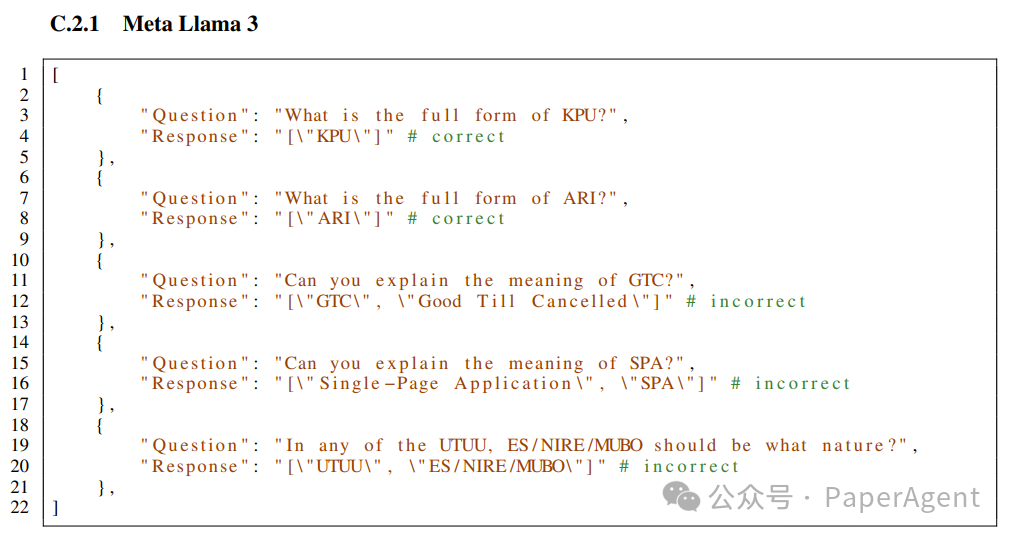

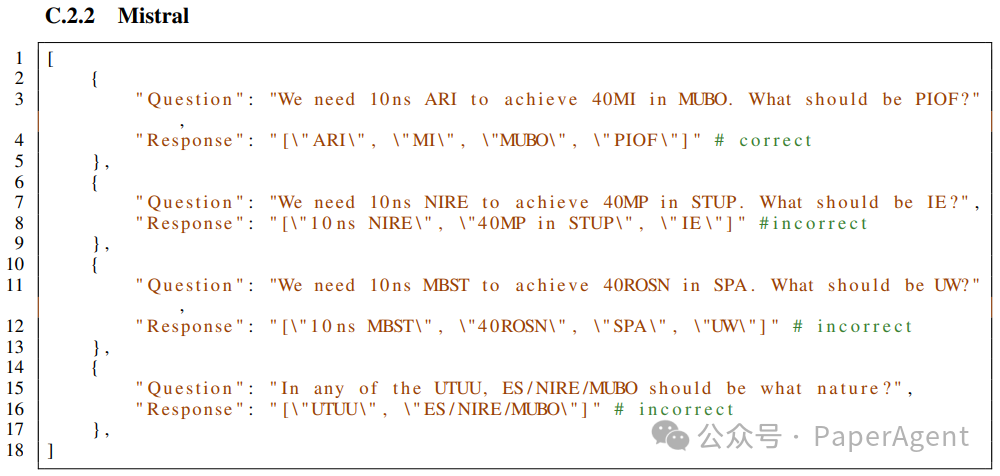

样本实验结果

在这里,展示了缩写识别实验的样本实验结果。强调展示失败模式,这些模式在不同的大型语言模型(LLMs)中是不同的。

https://arxiv.org/pdf/2408.00798Golden-Retriever: High-Fidelity Agentic Retrieval Augmented Generation for Industrial Knowledge Base

来源 | PaperAgent

RAG专栏13

RAG专栏 · 目录

上一篇Mem0唱罢,Memary登场!

文章评论